Przechowywanie nagranych materiałów wideo z monitoringu to element zabezpieczający interes wielu firm i instytucji publicznych. Bezpieczeństwo danych z kamer monitoringu jest niezwykle istotne zarówno w kontekście śledztw kryminalnych, jak i w przypadku monitorowania operacji biznesowych. W związku z tym, wybór odpowiedniego serwera do przechowywania zapisów z monitoringu nie powinien być dziełem przypadku, a dobrze przemyślanej decyzji.

Bizserver - blog o najnowszych technologiach serwerowych

Efektywność działania serwerów jest kluczowym elementem sprawnego funkcjonowania firm. Jednym z najnowszych kroków na drodze do doskonałości są procesory Intel Xeon E-2400, które wprowadzają nowe standardy wydajności i innowacji. W niniejszym artykule przyjrzymy się bliżej tym zaawansowanym jednostkom, omawiając, czym wyróżniają się od swoich poprzedników, przedstawiając ich modele oraz zastosowania w kontekście nowoczesnych potrzeb przedsiębiorstw.

Definicje pojęć: serwer, kontenery, Docker

Czym są serwery?

Serwery są nieodzownym elementem współczesnych przedsiębiorstw, pełniąc kluczową rolę w zapewnieniu dostępu do danych i zasobów. Jako centralne punkty zarządzania informacjami, serwery umożliwiają przedsiębiorstwom szybki dostęp do danych z każdego zakątka świata, dzięki wykorzystaniu chmury obliczeniowej. Korzyści płynące z posiadania własnego serwera obejmują nie tylko globalny dostęp, lecz także bezpieczeństwo danych oraz szybkie transfery informacji. Firmy hostingowe, które operują własnymi Data Centers, odgrywają kluczową rolę jako główni dostawcy serwerów, wspierając przedsiębiorstwa w utrzymaniu niezawodnej infrastruktury IT.

Czym są kontenery?

Kontenery to nowoczesna forma wdrażania usług online, wprowadzająca lekkie, zwirtualizowane systemy operacyjne. Przypominające plik zip, kontenery zawierają wszystko, co jest niezbędne do uruchomienia oprogramowania. Ich przenośność i łatwo skalowalna natura umożliwiają programistom pisanie kodu w dowolnym języku, zapewniając jednocześnie spójność działania w różnych środowiskach. Kontenery są zatem narzędziem nie tylko dla programistów, ale również dla przedsiębiorstw, poszukujących efektywnych i znormalizowanych rozwiązań w zakresie wdrażania aplikacji.

Czym jest Docker?

Docker, będący technologią kontenerową, rewolucjonizuje podejście do wirtualizacji poprzez zastosowanie konteneryzacji. Ta innowacyjna technologia umożliwia uruchamianie procesów aplikacji w izolowanych kontenerach, tworząc oddzielne instancje środowiska uruchomieniowego dla każdej aplikacji. Ta elastyczność pozwala na efektywne zarządzanie zasobami, co przekłada się na oszczędność i skuteczność. Docker stał się kluczowym narzędziem dla przedsiębiorstw, które pragną dynamicznie dostosowywać swoje środowisko pracy do zmieniających się potrzeb, bez konieczności inwestowania w dodatkowy sprzęt czy zasoby.

Wspólnie serwery, kontenery i Docker tworzą fundament nowoczesnej infrastruktury IT, pozwalając przedsiębiorstwom na efektywne zarządzanie danymi, wdrażanie usług online oraz elastyczne dostosowywanie się do dynamicznie zmieniających się warunków rynkowych. Dzięki temu, przedsiębiorstwa mogą być pewne, że ich technologiczna infrastruktura jest gotowa sprostać wyzwaniom współczesnego świata.

Główne różnice między serwerami i kontenerami

Izolacja i lekkość

Serwer: tradycyjna wirtualizacja maszyny

Tradycyjne serwery opierają swoje funkcjonowanie na klasycznej wirtualizacji maszyny, co oznacza, że każdy z nich działa jako osobna instancja systemu operacyjnego. Chociaż ta metoda zapewnia wysoki poziom izolacji, prowadzi również do nadmiernego zużycia zasobów, szczególnie w przypadku współdzielenia wielu serwerów na jednym hoście. Każdy serwer wymaga oddzielnego systemu operacyjnego, co skutkuje nieefektywnym wykorzystaniem mocy obliczeniowej i pamięci RAM.

Kontener: lekkość i elastyczność

Kontenery reprezentują nowoczesne podejście do izolacji, wykorzystując mechanizmy na poziomie systemu operacyjnego. Są one znacznie lżejsze niż wirtualne maszyny, ponieważ współdzielą jądro systemu operacyjnego z hostem. To pozwala na uruchamianie wielu kontenerów na jednym hoście, co skutkuje optymalizacją zużycia zasobów. Lekkość kontenerów przekłada się na większą elastyczność infrastruktury, umożliwiając efektywne wykorzystanie dostępnych zasobów.

Szybkość uruchamiania: błyskawiczność kontenerów

Serwer: opóźnienia wirtualnych maszyn

Wirtualne maszyny serwerowe, z uwagi na pełne odizolowanie, potrzebują czasu na uruchomienie. W przypadku dużych i skomplikowanych systemów, może to prowadzić do opóźnień w dostępie do aplikacji oraz procesie wdrażania.

Kontener: natychmiastowe uruchamianie

Kontenery uruchamiają się niemal natychmiastowo. Ta błyskawiczna prędkość uruchamiania kontenerów przyspiesza procesy deweloperskie, umożliwiając szybkie testowanie i skracając znacznie czas potrzebny na wdrażanie aplikacji. To istotna zaleta w dzisiejszym dynamicznym środowisku IT.

Zależności i środowisko: ułatwienie przenoszenia aplikacji

Serwer: skomplikowana konfiguracja

Serwer wymaga pełnej konfiguracji systemu operacyjnego oraz dodatkowych zależności, co może być czasochłonne i skomplikowane. Przenoszenie aplikacji między różnymi środowiskami może wymagać dodatkowych działań i konfiguracji.

Kontener: jednolite środowisko

Kontener zawiera wszystkie niezbędne zależności, tworząc jednolite środowisko. To istotnie ułatwia przenoszenie aplikacji między różnymi środowiskami, co jest szczególnie cenione w środowisku programistycznym. Programiści mogą być pewni, że aplikacja będzie działać zgodnie z oczekiwaniami niezależnie od miejsca, w którym jest uruchamiana.

Zasoby systemowe: optymalizacja zużycia

Serwer: wymagający zasobów

Wirtualizacja maszyny wymaga większej ilości zasobów, takich jak pamięć RAM i moc obliczeniowa procesora. Każda wirtualna maszyna potrzebuje swojego udziału zasobów, co może prowadzić do nieefektywnego wykorzystania dostępnych mocy obliczeniowych.

Kontener: optymalizacja zasobów

Dzięki lekkości kontenerów, możliwe jest uruchamianie wielu instancji na jednym hoście, co sprawia, że zużycie zasobów jest optymalizowane. Kontenery pozwalają na elastyczne dzielenie się zasobami, co jest kluczowe w przypadku dynamicznie rozwijających się środowisk biznesowych.

Skalowalność: dynamiczne dostosowywanie zasobów

Serwer: konieczność dodatkowego sprzętu

Skalowanie tradycyjnego serwera może wymagać dodatkowego sprzętu, generując koszty i wymagając czasu. Proces ten nie zawsze jest elastyczny i może prowadzić do nieefektywnego wykorzystania zasobów.

Kontener: elastyczność i łatwość skalowania

Kontenery są elastyczne i łatwo skalowalne. Dynamiczne dostosowywanie zasobów w zależności od bieżących potrzeb staje się prostsze, co zwiększa elastyczność infrastruktury. To szczególnie ważne w dzisiejszym środowisku, gdzie wymagania biznesowe mogą ulegać szybkim zmianom.

Podsumowanie

Odkrywanie różnic i podobieństw między tradycyjnymi serwerami a nowatorskimi kontenerami, takimi jak Docker, otwiera nowe perspektywy w zarządzaniu aplikacjami. Docker jako rewolucyjne narzędzie, nie tylko ułatwia przenośność aplikacji między różnymi środowiskami, ale również wprowadza bardziej efektywne wykorzystanie zasobów sprzętowych.

Warto wnikliwie zgłębiać te tematy i eksperymentować z technologią kontenerową, aby lepiej zrozumieć, jak może ona przyczynić się do efektywności i innowacyjności w dziedzinie IT. Wybór pomiędzy tradycyjnym serwerem a Dockerem staje się indywidualnym wyborem, który powinien być dostosowany do konkretnych potrzeb i celów organizacji.

Views

Views

Liked

Liked

W świecie informatyki, zrozumienie różnic między tradycyjnymi serwerami a nowoczesnymi rozwiązaniami opartymi na kontenerach, takimi jak Docker, staje się niezwykle kluczowe. Artykuł ten ma na celu rozwianie niejasności i przedstawienie istotnych różnic oraz podobieństw pomiędzy serwerami a technologią kontenerową, szczególnie w kontekście narzędzia Docker.

Marka Supermicro dba nie tylko o spełnianie oczekiwań jej klientów, ale także o wyprzedzanie ich potrzeb. Najlepszym tego dowodem są nowości od Supermicro, które prezentujemy w niniejszym wpisie. Zapraszamy do jego lektury!

Producenci sprzętu komputerowego stale podnoszą poprzeczkę, dążąc do zapewnienia użytkownikom najnowszych i najbardziej zaawansowanych technologii. W tym kontekście, procesory Intel Xeon Scalable 5. generacji stanowią kolejny krok naprzód, oferując innowacje, które mogą rewolucjonizować obszar przetwarzania danych i obliczeń w przedsiębiorstwach na całym świecie.

Laboratoria badawcze i rozwojowe stanowią dynamiczne środowisko, w którym każdego dnia mogą rodzić się innowacje. W takim kontekście kluczową rolę odgrywa niezawodna infrastruktura, a serwer stanowi fundament efektywnego przetwarzania danych, składowania informacji oraz obsługi różnorodnych zastosowań naukowych. W tym artykule przyjmiemy bliższe spojrzenie na kluczowe cechy, jakimi powinien się cechować serwer dedykowany do laboratorium badawczemu, jednocześnie prezentując kilka rekomendacji sprzętu dostępnego w ofercie sklepu Bizserver.

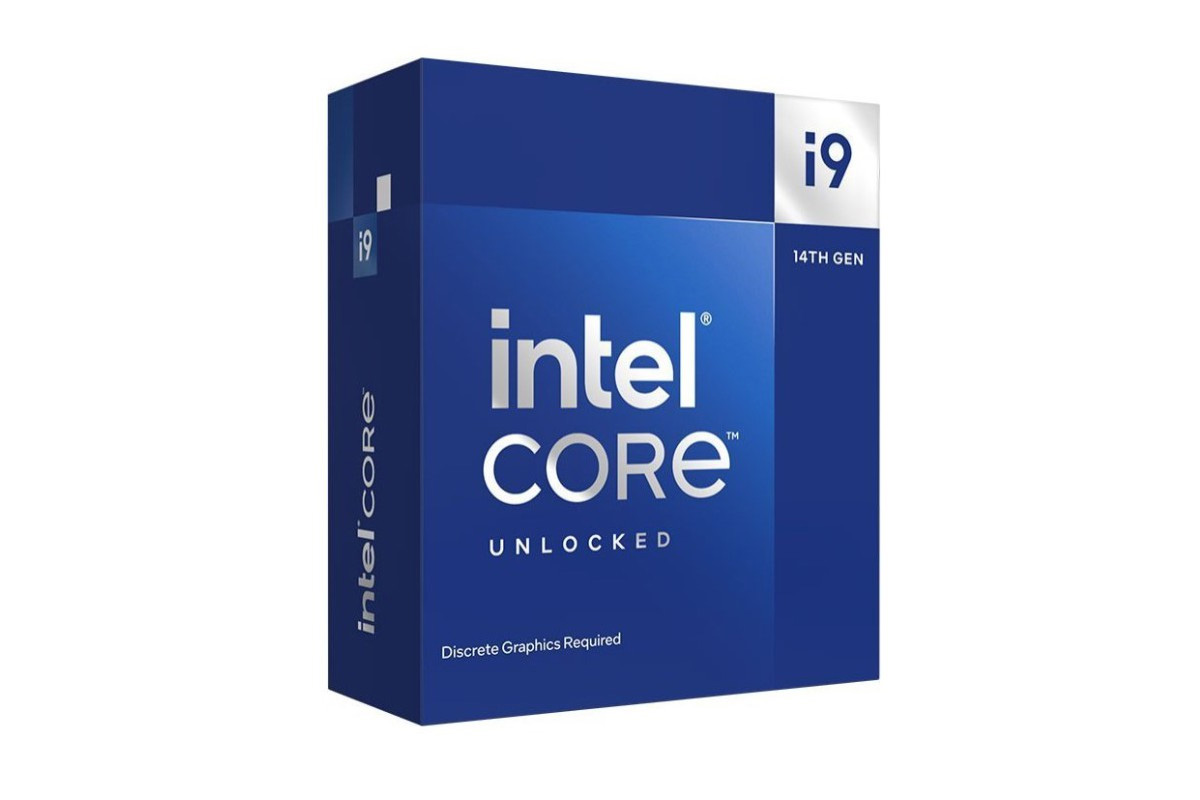

Nowa seria procesorów Intel Core 14. generacji jest już dostępna, a wielu entuzjastów zastanawia się, czy naprawdę warto zainwestować w te nowe modele, zwłaszcza jeśli już korzystają z poprzednich generacji. Oto kilka kluczowych aspektów, które warto wziąć pod uwagę przy ocenie, czy te procesory naprawdę reprezentują znaczący postęp.

Obudowa serwera to więcej niż tylko estetyka - to serce wydajności, chłodzenia i bezpieczeństwa danych. Przybliżamy, na co zwracać uwagę przy wyborze obudowy, aby sprostać różnorodnym potrzebom użytkowników, oraz prezentujemy polecane modele. Zapraszamy do lektury!

W niniejszym artykule przybliżamy różnorodne metody zabezpieczania danych na serwerze, które są niezbędne do ochrony przed utratą, nieautoryzowanym dostępem czy atakami cybernetycznymi. Dowiedz się, jak kompleksowy zestaw technologii i strategii może skutecznie chronić cenne informacje i zapobiec poważnym konsekwencjom dla przedsiębiorstw i instytucji.

Sztuczna inteligencja coraz bardziej wpływa na nasze życie. W związku z tym kluczowym staje się poszukiwanie wydajnych i innowacyjnych rozwiązań serwerowych. Jednym z najnowszych trendów w tej dziedzinie jest wykorzystanie chłodzenia cieczą, które oferuje nie tylko wyjątkową wydajność, ale i efektywność energetyczną.

W erze cyfrowej, gdzie awarie serwerów mogą prowadzić do katastrofalnych konsekwencji, istotne jest zrozumienie, jak przeszłe incydenty wpłynęły na dzisiejsze podejście do bezpieczeństwa danych. Niniejszy artykuł rzuca światło na największe awarie serwerów w historii IT, oferując cenne lekcje na temat znaczenia niezawodnej infrastruktury technologicznej.

W niniejszym artykule wskazujemy, jakie cechy powinna posiadać idealna obudowa serwerowa oraz którzy producenci obudów serwerowych stoją na czele innowacji, i jakie rozwiązania oferują, aby sprostać potrzebom najbardziej wymagających klientów.

Karty graficzne do serwerów stanowią kluczowy element dla organizacji i firm, które wymagają wysokiej wydajności obliczeniowej i graficznej. Warto przyjrzeć się różnym producentom, aby dokonać świadomego wyboru. Poniżej przedstawiamy listę najważniejszych producentów kart graficznych do serwerów.

Narzędzia umożliwiające zdalne zarządzanie stają się nieodzownym elementem w sprawnym funkcjonowaniu organizacji. W tym kontekście, Supermicro Intelligent Platform Management Interface (IPMI) wyróżnia się jako potężne narzędzie, które umożliwia administratorom efektywne kontrolowanie, monitorowanie i konfigurowanie serwerów nawet z odległego miejsca. IPMI to swoiste okno do serwerowego świata, które oferuje nie tylko zdalny dostęp do systemu, ale także umożliwia podejmowanie kluczowych decyzji administracyjnych w czasie rzeczywistym.

Router to kluczowe urządzenie zapewniające dostęp do internetu w naszych domach. Dlatego też wybór odpowiedniego modelu jest istotny, zwłaszcza gdy mamy ograniczony budżet. W artykule tym postaramy się rozjaśnić, na co zwracać uwagę, szukając routerów w przedziale cenowym do 300 zł.

Ostatnie nowości od Supermicro obejmują szereg zaawansowanych płyt głównych. Wśród nich znajdują się modele takie jak MBD-X13DEI, MBD-X13SRA-TF, MBD-X13SWA-TF, MBD-X13SEW-TF, MBD-X13SEW-F i MBD-X13SEM-TF, które zostały zaprojektowane z myślą o profesjonalnych zastosowaniach. Charakteryzują się one obsługą najnowszych procesorów Intel Xeon, zaawansowanymi możliwościami pamięci RAM DDR5 oraz szeroką gamą opcji rozbudowy, w tym portów PCIe 5.0, NVMe i zaawansowanymi opcjami sieciowymi.

Technologia rozwija się w zawrotnym tempie. To sprawia, że przedsiębiorstwa coraz częściej decydują się na leasing serwerów. Ten model biznesowy pozwala na elastyczne dostosowanie się do zmieniających się potrzeb, bez konieczności inwestowania ogromnych sum w zakup sprzętu. W niniejszym artykule przyjrzymy się, na czym polega leasing serwera, ile może kosztować oraz gdzie można znaleźć serwery dostępne w leasingu.

W dzisiejszym dynamicznym świecie, w którym technologia odgrywa znaczącą rolę, serwer aplikacji stanowi niewątpliwie jeden z kluczowych fundamentów infrastruktury informatycznej. Jest to nieodzowny element, który umożliwia efektywne dostarczanie aplikacji i usług w sposób nie tylko wydajny, lecz także niezawodny. W niniejszym artykule dokładniej przyjrzymy się roli serwera aplikacji, omówimy różne rodzaje serwerów aplikacji dostępne na rynku i przybliżymy liczne korzyści, jakie przynosi to rozwiązanie.

W niniejszym artykule przyjrzymy się bliżej, czym jest serwer czasu NTP, jakie pełni funkcje i dlaczego jest tak istotny nie tylko dla instytucji finansowych, ale także dla każdego przedsiębiorcy dbającego o efektywność swojego środowiska IT. Poznamy również, w jaki sposób serwery NTP wpływają na różne aspekty działalności firm i organizacji. Zapraszamy do lektury!

W erze, w której przechowywanie i przetwarzanie ogromnych ilości danych staje się nieodłączną częścią naszego życia cyfrowego. Istnieją technologie, które działają w cieniu, ale odgrywają niezwykle istotną rolę w zapewnieniu wydajności i niezawodności w obszarze przechowywania danych. Jedną z takich kluczowych technologii są karty Fibre Channel, często określane jako karty HBA (Host Bus Adapter).

Innowacyjne "dyski hermetyczne" otwierają nowe możliwości w efektywnym i niezawodnym przechowywaniu danych. W niniejszym artykule przybliżymy charakterystykę i zalety dysków twardych wypełnionych helem, a także przedstawimy, dlaczego ta technologia zdobywa coraz większe uznanie na rynku technologicznym. Zapraszamy do lektury, aby dowiedzieć się więcej o tej fascynującej technologii i jej wpływie na przyszłość przechowywania danych.

Czy zastanawiali się Państwo kiedykolwiek, jak ważna jest solidna gwarancja przy zakupie sprzętu IT? Firma Supermicro, lider w dziedzinie innowacyjnych rozwiązań technologicznych, oferuje nie tylko wysokiej jakości sprzęt, ale także różnorodne opcje gwarancyjne, które zaspokoją nawet najbardziej wymagające potrzeby klientów. Zapraszamy do zapoznania się z naszym artykułem, który przedstawia różne rodzaje gwarancji oferowanych przez Supermicro i wyjaśnia, dlaczego są one tak istotne w decyzjach zakupowych oraz w utrzymaniu efektywności i niezawodności infrastruktury IT.

W dzisiejszym świecie instytucje finansowe odgrywają kluczową rolę w gospodarce, zarządzając ogromnymi ilościami danych, transakcjami i informacjami o klientach. W tym kontekście serwery pełnią niezwykle istotną funkcję, zapewniając niezbędną infrastrukturę do przetwarzania, przechowywania i zabezpieczania tych danych. Dlatego też przybliżymy rolę serwera w instytucjach finansowych oraz zwrócimy uwagę na rekomendacje dotyczące sprzętu, które powinny być brane pod uwagę przy wyborze serwera dla banku czy innej instytucji finansowej.

W dzisiejszych czasach, w erze cyfryzacji i rosnącej liczby urządzeń podłączonych do Internetu, inteligentne rozwiązania brzegowe stają się nieodłącznym elementem naszej codzienności. Jednym z liderów w dziedzinie zaawansowanych rozwiązań IT jest firma Supermicro, która wychodzi naprzeciw potrzebom rynku, prezentując Supermicro Outdoor Edge - serię produktów zaprojektowanych specjalnie dla tego dynamicznego sektora. W niniejszym artykule przyjrzymy się temu, czym są rozwiązania Supermicro Outdoor Edge oraz jakie korzyści niosą ze sobą dla różnych branż i zastosowań.

W dzisiejszym świecie, w którym internet stał się nieodłączną częścią naszego życia, jakość i niezawodność sieci bezprzewodowej stają się coraz ważniejsze. Coraz więcej urządzeń domowych jest podłączonych do sieci, a potrzeba szybkiego i stabilnego dostępu do internetu jest nieustannie rosnąca. Na szczęście istnieje rozwiązanie, które może spełnić te oczekiwania: Mesh WiFi. W tym artykule zgłębimy tajniki Mesh WiFi, jego działanie oraz korzyści, jakie oferuje.

W dzisiejszych czasach rosnące zapotrzebowanie na nowoczesne technologie w szkolnictwie stawia przed placówkami edukacyjnymi wiele wyzwań. Jednym z kluczowych elementów infrastruktury IT jest serwer, który odgrywa niezwykle istotną rolę w zapewnieniu bezpieczeństwa danych oraz efektywności pracy uczniów i nauczycieli. Wybór odpowiedniego serwera dla pracowni komputerowej jest zadaniem wymagającym uwagi i staranności, ponieważ to on decyduje o funkcjonalności i wydajności całej sieci szkolnej.

Nie da się ukryć, że w obecnym świecie informatyki, gdzie zarządzanie infrastrukturą IT staje się coraz bardziej złożone i wymagające, rośnie popyt na rozwiązania, które będą mogły ułatwić działanie wielu firm czy instytucji.

Świat IT nieustannie się zmienia poprzez implementację coraz to nowszych technologii. Nowe trendy można również zaobserwować wśród użytkowników, którzy decydują się na nieco odmienny montaż kart graficznych we własnych urządzeniach. Mianowicie zamiast tradycyjnego montażu bezpośrednio w płycie głównej, decydują się oni na pionową konfigurację w innym miejscu obudowy. Oczywiście, aby było to możliwe, niezbędne jest użycie taśmy przedłużającej, którą spotkać można pod nazwą riser. Jednak przed przystąpieniem do zmodyfikowanej instalacji karty graficznej warto rozeznać się, jakie risery będą do tego celu najlepsze.

Era cyfrowej transformacji i dynamicznego rozwoju technologii informacyjnych przynosi ze sobą wyjątkowe wyzwania i możliwości. Współczesne centra danych wymagają nie tylko potężnej mocy obliczeniowej, ale również wydajnych i elastycznych rozwiązań. W tej kategorii rozwiązań wyróżnia się marka Supermicro, która od lat jest czołowym dostawcą innowacyjnych systemów serwerowych.

W erze cyfrowej transformacji, gdzie dostęp do usług online stał się nieodłączną częścią naszego życia, pojęcia hostingowego środowiska zdobywają coraz większe znaczenie. Dla osób niezwiązanych głęboko z technologią, hosting strony internetowej, aplikacji czy danych może wydawać się czymś jednym. Niemniej jednak, w tym technologicznym labiryncie istnieją dwie główne kategorie, które rządzą hostingiem: hosting w chmurze i tradycyjny hosting na serwerze.

W dzisiejszym cyfrowym świecie centra danych odgrywają kluczową rolę jako centra przetwarzania i przechowywania danych. To specjalnie zaprojektowane miejsca, gdzie gromadzone są zasoby IT, takie jak serwery czy urządzenia sieciowe, umożliwiające przetwarzanie i dostarczanie usług cyfrowych.

W dzisiejszych czasach, w miarę rozwoju internetu i technologii cyfrowych, hosting stał się kluczowym elementem dla każdej firmy czy osoby, która posiada stronę internetową, aplikację internetową lub chce udostępnić treści online. Hosting to usługa polegająca na udostępnianiu przestrzeni na serwerach, dzięki której witryny i aplikacje mogą być dostępne online 24/7. W celu zapewnienia sprawnego i niezawodnego działania swojej witryny lub aplikacji, kluczowe jest wybranie odpowiedniego serwera do hostingu.

Dynamicznie rozwijający się rynek technologii informatycznych nieustannie wprowadza nowe produkty, które mają na celu sprostać rosnącym wymaganiom klientów. Supermicro, znany producent sprzętu komputerowego, nie stoi w miejscu i regularnie wprowadza na rynek innowacyjne rozwiązania. W tym artykule przyjrzymy się nowym produktom od Supermicro, które w ostatnim czasie pojawiły się na rynku. Produkty te można znaleźć w ofercie sklepu Bizserver.

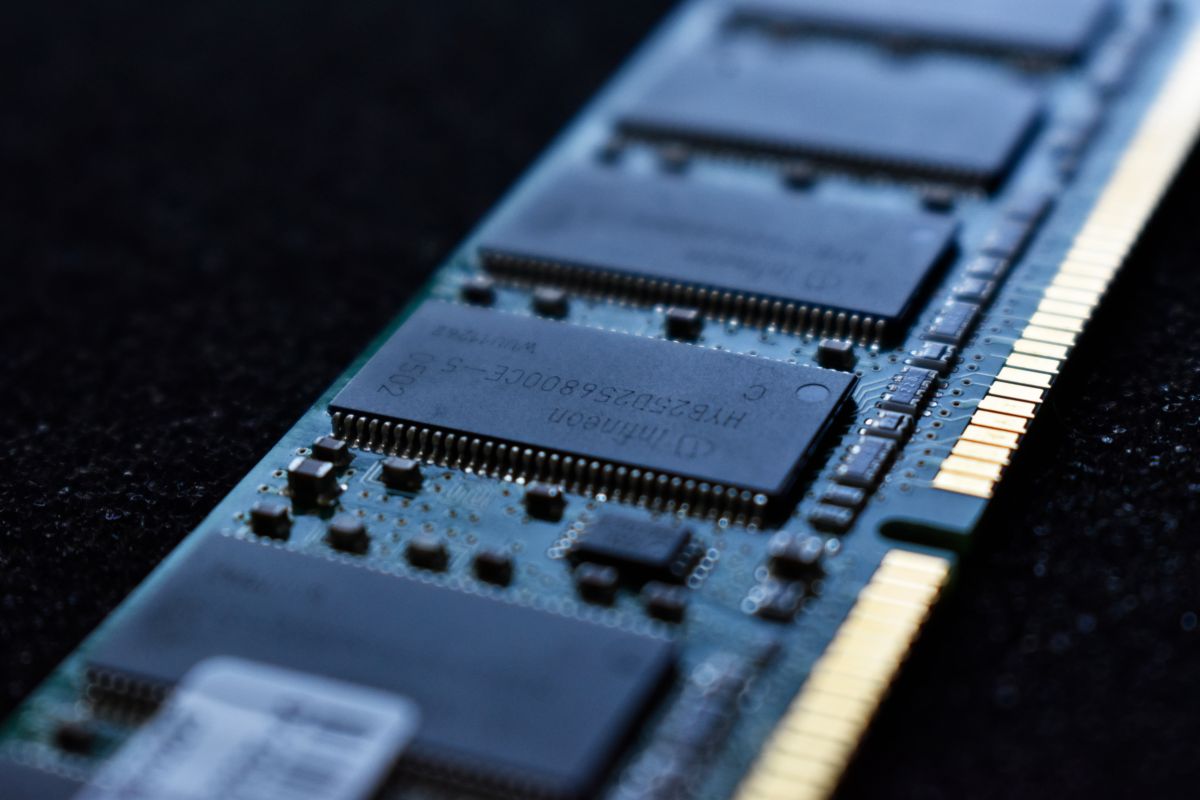

Pamięć RAM (Random Access Memory) jest jednym z kluczowych elementów każdego komputera. Jest to rodzaj pamięci, która przechowuje dane tymczasowo, umożliwiając szybki dostęp do nich przez procesor. W miarę rozwoju technologii, pamięci RAM ulegają zmianie i poprawie wydajności, dlatego ważne jest, aby wiedzieć, jaki rodzaj pamięci RAM znajduje się w naszym komputerze. W tym artykule omówimy kilka sposobów, jak sprawdzić rodzaj pamięci RAM.

W dzisiejszym rozwijającym się świecie technologii, High Bandwidth Memory (HBM) to rewolucyjna technologia pamięci, która odgrywa kluczową rolę w układach graficznych, sztucznej inteligencji i superkomputerach. HBM charakteryzuje się trójwymiarową strukturą i wysoką przepustowością, co przyczynia się do zwiększenia wydajności systemów komputerowych.

Podobieństwa i różnice między routerem a modemem są kluczowe dla zrozumienia tych dwóch urządzeń, które odgrywają istotne role w zapewnieniu dostępu do internetu oraz w budowaniu sieci komputerowych. Zarówno router, jak i modem, mają na celu zapewnienie połączenia między urządzeniami a światem internetu, ale ich funkcje, zastosowania i technologie różnią się.

Moduł Small Form-factor Pluggable, czyli SFP, to standardowy element używany w urządzeniach sieciowych do przesyłania danych. Zgodny z normami MSA, jest powszechnie stosowany i kompatybilny z różnymi producentami sprzętu sieciowego, co zapewnia elastyczność wyboru dostawcy.

Kabel sieciowy, znany również jako kabel internetowy, to fizyczne medium transmisji używane do przesyłania danych między urządzeniami w sieci komputerowej.

Green Computing, znane również jako Green IT lub ekologiczne komputery, to koncepcja i praktyka związana z minimalizowaniem wpływu technologii informacyjno-komunikacyjnych (IT) na środowisko naturalne. Polega ona na podejmowaniu świadomych działań w celu zmniejszenia zużycia energii, ograniczenia emisji gazów cieplarnianych oraz efektywnego zarządzania zasobami w dziedzinie informatyki.

Rozwój technologii informacyjno-komunikacyjnych (TIK) oraz rosnące wymagania dotyczące przetwarzania danych stawiają przed przedsiębiorstwami wyzwania związane z infrastrukturą IT. Właściwe zarządzanie serwerami i sprzętem komputerowym jest kluczowe dla efektywnego funkcjonowania organizacji. Jednak koszty zakupu nowych serwerów mogą być znaczące, szczególnie dla mniejszych przedsiębiorstw. W takiej sytuacji coraz częściej sięgamy po alternatywne rozwiązania, takie jak serwery refabrykowane i używane. Zarówno serwery refabrykowane, jak i używane oferują szereg korzyści, które przyciągają uwagę przedsiębiorców. W tym artykule przyjrzymy się podobieństwom i różnicom między tymi dwoma rodzajami serwerów.

Serwerowa pamięć RAM, często nazywana pamięcią ECC (Error Correcting Code), to specjalny rodzaj pamięci RAM używany głównie w serwerach i systemach o wysokich wymaganiach dotyczących niezawodności i bezpieczeństwa danych. Serwery często obsługują duże obciążenia pracy i gromadzą istotne informacje, dlatego pamięć RAM w nich jest projektowana w taki sposób, aby minimalizować ryzyko błędów, utraty danych i awarii systemu.

Sztuczna inteligencja (SI) jest dziedziną nauki, która zajmuje się tworzeniem systemów komputerowych zdolnych do wykonywania zadań, które normalnie wymagałyby ludzkiej inteligencji. SI wykorzystuje różne techniki, takie jak uczenie maszynowe, przetwarzanie języka naturalnego, rozpoznawanie obrazów i głosu, aby umożliwić komputerom podejmowanie decyzji, uczenie się na podstawie doświadczenia i wykonywanie złożonych zadań.

W dzisiejszej erze technologii i rosnącej roli komputerów i sieci w biznesowym świecie, administratorzy serwerów odgrywają kluczową rolę w zapewnieniu sprawnego działania infrastruktury IT.

W dzisiejszych czasach gry komputerowe stały się niezwykle popularna i dynamicznie rozwijającą się formą rozrywki. Miliony ludzi na całym świecie poświęcają wiele godzin tygodniowo na grę w swoje ulubione tytuły. Wraz z rozwojem technologii i coraz większym zapotrzebowaniem na płynną rozgrywkę, coraz więcej graczy zaczyna rozważać możliwość posiadania własnego serwera do gier w domu.

W dzisiejszych czasach, kiedy coraz więcej urządzeń w naszych domach staje się inteligentnych i podłączonych do sieci, automatyka domowa stała się niezwykle popularna. Home Assistant to jeden z wiodących systemów open-source, który umożliwia zarządzanie i kontrolę różnych aspektów naszego domu, takich jak oświetlenie, ogrzewanie, klimatyzacja, urządzenia multimedialne, alarmy i wiele więcej. Jednak aby Home Assistant działał sprawnie i efektywnie, niezbędny jest dedykowany serwer.

W dzisiejszym dynamicznym środowisku biznesowym serwery odgrywają kluczową rolę w zapewnianiu płynności działania firm i organizacji. Są one nieodzownym elementem infrastruktury informatycznej, obsługującym przetwarzanie danych, udostępnianie zasobów oraz hostowanie aplikacji. Z tego powodu utrzymanie serwerów w optymalnym stanie technicznym i zapewnienie im długiej żywotności ma ogromne znaczenie dla efektywności i stabilności działania przedsiębiorstwa.

Wirtualizacja serwerów jest zaawansowaną technologią, która umożliwia tworzenie wirtualnych instancji serwerów na jednym fizycznym serwerze. Dzięki temu można skonsolidować wiele aplikacji i usług na jednej maszynie, co przynosi wiele korzyści dla przedsiębiorstw i organizacji.

Jednym z najważniejszych sprzętów, jakie znajdują się w infrastrukturze informatycznej szpitala, są bez wątpienia serwery. Serwery w szpitalach znajdują wiele zastosowań i są jednostkami krytycznymi dla funkcjonowania całego systemu. Każdy szpital, który zamierza wyposażyć swój dział IT w serwer, stoi przed trudnym wyborem, ponieważ serwer musi w pełni odpowiadać zapotrzebowaniu dla przewidzianych operacji wykonywanych na serwerze. Na co zwrócić uwagę przed zakupem i jak dobrać odpowiednie parametry dla swojego sprzętu? Poniższy artykuł postara się przybliżyć, na jakie cechy warto zwrócić uwagę oraz przedstawi kilka rekomendacji sprzętowych.

W obecnych czasach każda publiczna oraz prywatna placówka szkolna potrzebuje dysponować serwerem, który jest nieodłączną częścią infrastruktury informatycznej. Na rynku IT jest wielu producentów serwerów, a ilość dostępnych konfiguracji może przysporzyć o ból głowy. Poniższy artykuł postara się przedstawić, na co zwrócić uwagę przed zakupem, jakie są najważniejsze cechy serwera do szkoły, a także co rekomendują specjaliści.

Zasilacz awaryjny UPS jest jednym z niezbędnych urządzeń, jakie potrzebuje każde przedsiębiorstwo. To zainspirowało nas do stworzenia rankingu TOP 10 najpopularniejszych modeli zasilaczy awaryjnych UPS, wybieranych przez klientów Bizserver w 2023 roku.

Branża IT cechuje się głównie specjalistycznym słownictwem, dlatego w poniższym słowniku zostało wyjaśnionych wiele pojęć.

Serwer to jedno z podstawowych urządzeń, jakie potrzebuje każde przedsiębiorstwo. To zainspirowało nas do stworzenia rankingu TOP 10 najpopularniejszych modeli serwerów RACK wybieranych przez użytkowników Bizserver w 2023 roku.

W niniejszym artykule zostanie przedstawionych kilka sposobów, jak uchronić komputer przed utratą danych, a tym samym zaoszczędzić nerwów, czasu i pieniędzy na szukanie ekspertów w dziedzinie odzyskiwania danych.

Infrastruktura IT opiera się na usługach sieciowych, które są złożonym, lecz na pozór prostym systemem. Sieć stanowi fundament większej struktury, której celem jest zapewnienie ciągłości procesów biznesowych dla wszystkich użytkowników.

W dzisiejszych czasach poczta elektroniczna jest nieodłącznym elementem pracy w większości firm. Niezależnie od tego, czy prowadzimy małą firmę, czy duże przedsiębiorstwo, prawdopodobnie potrzebujemy sposobu na przesyłanie wiadomości e-mail. Kiedy już zdecydujemy się na pocztę firmową, pojawia się pytanie, co będzie lepsze - własny serwer pocztowy czy usługa zewnętrzna? W tym artykule omówimy zalety i wady obu opcji, aby pomóc w podjęciu właściwej decyzji.

Procesory graficzne (GPU) i procesory ogólnego przeznaczenia (CPU) to dwa rodzaje procesorów używanych w dzisiejszych komputerach. Oba te rodzaje procesorów różnią się od siebie pod względem funkcjonalności, zastosowań i specyfikacji technicznych. W tym artykule przeanalizujemy podobieństwa i różnice między CPU a GPU.

RTX 4080 i RTX 4090 to karty graficzne produkowane przez firmę NVIDIA. NVIDIA jest jednym z największych i najważniejszych producentów kart graficznych na świecie, znanym z tworzenia wysokiej jakości produktów zarówno dla konsumentów, jak i dla profesjonalistów.

Supermicro to ceniony na całym świecie producent serwerów, który oferuje niezwykle wydajne i niezawodne rozwiązania dla różnych branż. Firma ta jest znana z produkcji serwerów, które spełniają nawet najwyższe wymagania swoich klientów. Wśród najnowszych osiągnięć Supermicro jest nowa generacja płyt głównych i platform opartych na serii AMD H13.

Firma AMD zapowiedziała właśnie wprowadzenie na rynek nowej rodziny procesorów, oznaczonej symbolem 9004. Jest to kolejny krok w rozwoju firmy w kierunku coraz wydajniejszych i bardziej zaawansowanych technologicznie procesorów.

PING to bardzo ważny aspekt funkcjonalności sieci. Czym jest PING, co wpływa na PING i jak poprawić PING - o tym i kilku innych kwestiach przeczytasz w niniejszym artykule.

Prezentujemy listę najbardziej znanych producentów serwerów na świecie. Czy znasz te marki? Czy wiesz jak powstały? Sprawdź koniecznie!

Czym różnią się obudowy komputerowe od obudów serwerowych? Dowiedz się na przykładzie obudów marki Dell

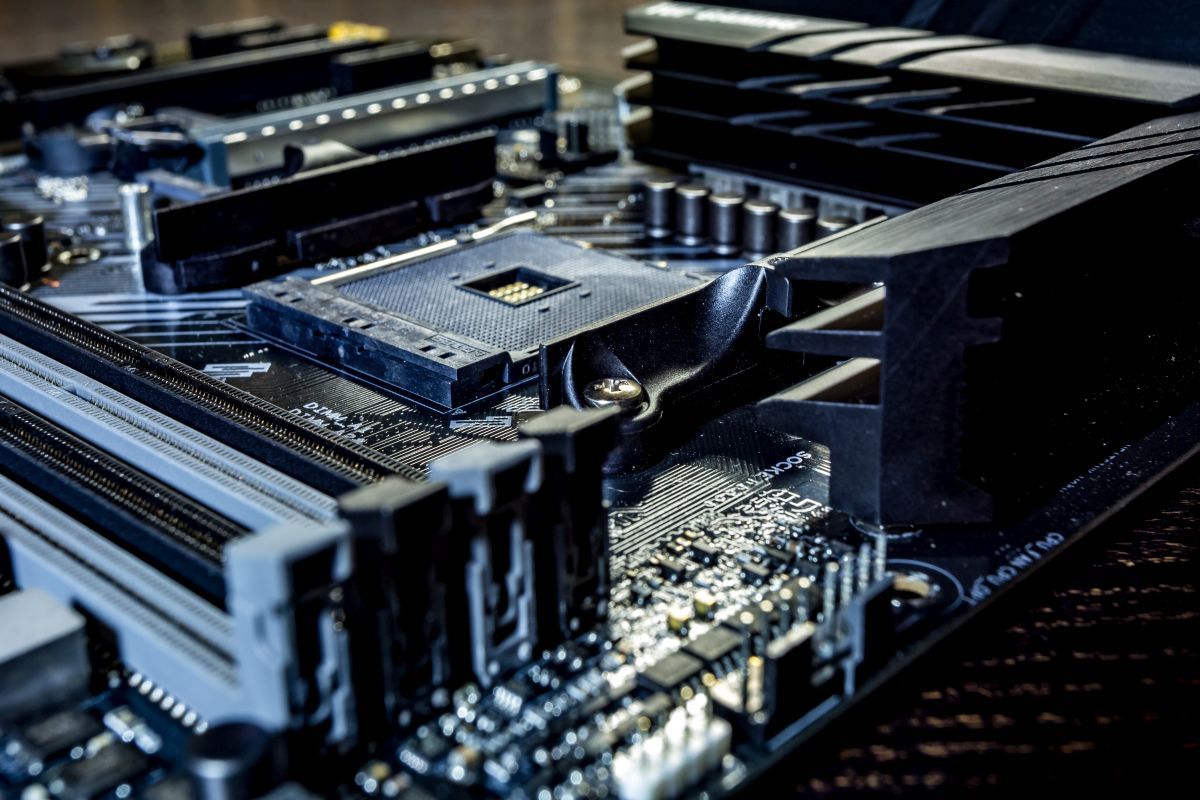

Serwer składa się z wielu komponentów. W niniejszym wpisie prezentujemy elementy wchodzące w skład typowego serwera.

Przekonaj się dlaczego warto regularnie wykonywać kopie zapasowe i w jaki sposób wykonywać to poprawnie.

Dowiedz się czym jest hosting i jak sprawdzić, na którym hostingu znajduje się dana strona internetowa.

W niniejszym artykule podpowiadamy, który wybrać serwer dla bloga internetowego: hosting współdzielony, serwer VPS czy dedykowany serwer.

Wyznaczenie obszaru do przechowywania serwerów i sprzętu IT może wydawać się zbędne w przypadku małej firmy. Zaplanowanie konfiguracji serwerowni lub szafy serwerowej może zająć wiele godzin, a mało kto w małej czy średniej wielkości firmie chce lub potrafi się tym zajmować.

Gdy na wykupionym przez nas serwerze współdzielonym zaczyna brakować miejsca, lub gdy z uwagi na rosnącą przepustowość brakuje wyczerpujemy dostępny plan taryfowy, czas rozejrzeć się za nowym serwerem. Na szczęście oferta na rynku jest dziś na tyle duża, że z upgradem i przesiadką na bardziej zaawansowany serwer nie będzie jakichkolwiek problemów.

Supermicro jest trzecim co do wielkości producentem oraz dostawcą systemów serwerowych dla klientów korporacyjnych na świecie i wciąż inspiruje klientów swoimi innowacyjnymi, błyskotliwymi projektami i podejściem do wyspecjalizowanych rozwiązań serwerowych dla szerokiej gamy obszarów biznesowych. Nie musisz być korporacją, aby korzystać z zalet własnego serwera Supermicro: dzięki szerokiemu spektrum urządzeń, Supermicro obsługuje całą branżę, od małych start-upów, poprzez klasyczne średnie firmy, aż po największe światowe korporacje, firmy i centra danych. Cała paleta produktów jest niezwykle skalowalna i oferuje odpowiednie systemy dla każdej wielkości budżetu i wymagań.

Zakup serwera dla firm wiąże się z niemałymi wydatkami. Przed podjęciem decyzji warto skonsultować się ze specjalistami branży IT, którzy wytyczą prawidłowy kierunek dla naszej inwestycji. Ograniczymy tym samym ryzyko przeprowadzenia nietrafionego przedsięwzięcia i źle wydanych pieniędzy.

Przy wyborze pomieszczenia mieszczącego sprzęt wart dziesiątki czy setki tysięcy złotych nie należy kierować się oszczędnościami. W najgorszym wypadku ubezpieczyciel zwróci koszt utraconych jednostek. Jednak wraz ze sprzętem zniszczeniu ulegają najczęściej dane, również te poddane backupowi, a to może oznaczać dla przedsiębiorcy poważne kłopoty. Dla wielu będzie to oznaczało koniec biznesu.

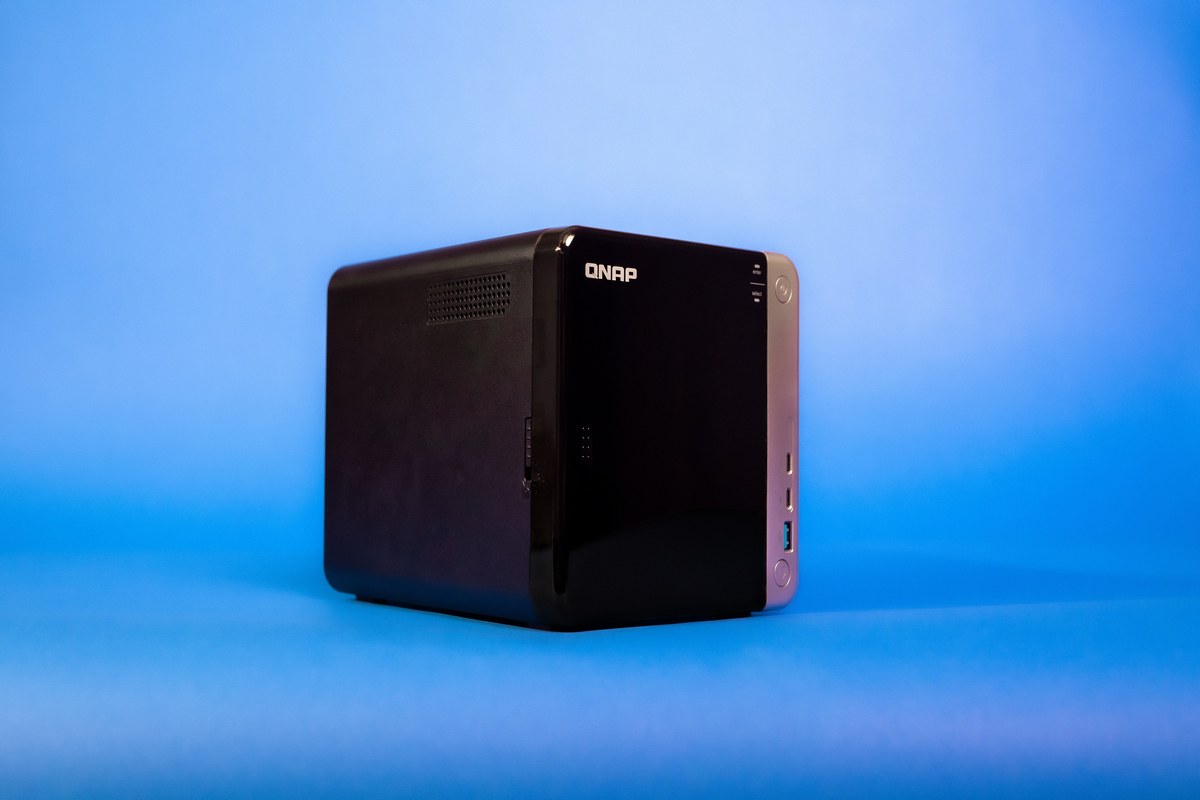

Przy rosnącym zapotrzebowaniu na przestrzeń dla danych, użytkownicy stoją przed wyborem odpowiedniego sposobu ich przechowywania. Cena, wydajność, dostępność, łatwość obsługi, bezpieczeństwo – te i inne parametry należy wziąć pod uwagę, decydując się na zakup usługi lub sprzętu. W tym tekście przyjrzymy się trzem opcjom: serwerom własnym (NAS), wirtualnym (VPS) oraz w chmurze.

Wybór szafy pod serwer rack jest tylko pozornie łatwym zadaniem. W rzeczywistości mieszczą one sprzęt teleinformatyczny kosztujący kilkanaście albo kilkadziesiąt tysięcy, np. m serwer 1u, serwer rack 1u czy serwer rack 2u. Do głównych zadań szafy rackowej należy zapewnienie bezpieczeństwa jednostek poprzez właściwą wentylację oraz zasilanie. Dobrze, jeśli przy okazji umożliwia ona łatwą rozbudową w przypadku zmiany konfiguracji sprzętu.

Czym jest kolokacja i jak z niej skorzystać przy pomocy firmy Bizserver

Serwery zazwyczaj są niezawodne, usterki nie zdarzają się zbyt często. Jednak jak każde urządzenie, one również mogą ulec uszkodzeniu. Poniżej przedstawiamy w jaki sposób poradzić sobie z kilkoma możliwymi problemami.

Problemy podczas pracy z serwerem:

1. Nie można połączyć się z siecią.

Zazwyczaj jest to spowodowane brakiem odpowiednich sterowników. Jednym z najprostszych oraz najbardziej zadowalających rozwiązań jest instalacja najnowszych sterowników.

Może to być również spowodowane zakłóceniami powodowanymi pracą innych urządzań w sieci, np. firewall. W takim przypadku należy odłączyć serwer od sieci i spróbować podłączyć go przez kabel crossover z innym urządzeniem sieciowym.

2. Dyski HDD wypadają z macierzy RAID.

Może być spowodowane na przykład przez niesprawny wentylator, który wywołuje silne wibracje. W takim przypadku należy naprawić lub wymienić wentylator.

3. Serwer generuje sygnał akustyczny.

Oznacza problem z co najmniej jednym komponentem takim jak:

- Płyta Główna,

- Kontroler - jeśli jest utworzona macierz dyskowa,

- Backplane

- Redundantne zasilanie - uszkodzenie jednego z zasilaczy,

- bądź innym elementem serwera.

4. Nie można uruchomić serwera.

W ostateczności może dojść do sytuacji, gdy trzeba będzie wymienić podzespoły – pamięć RAM, zasilacz, procesor, płyta główna.

Jednak zanim się za to zabierzemy, możemy dokładnie przyglądnąć się serwerowi. Należy zwrócić uwagę, czy mrugają lub świecą się diody serwera i czy serwer wydaje piszczące dźwięki. W większości przypadków w instrukcji obsługi danego serwera znajdziemy informację, co oznacza dana lampka oraz sposób w jaki świeci – czy mruga, lub jest stały sygnał.

Co ciekawe ta maszyna jest skonstruowana w taki sposób, że potrafi „zakomunikować” nam co się w niej zepsuło. Jest to komunikacja dźwiękowa, trochę przypominająca alfabet Mors'a. Jednak w tym przypadku generowane sygnały mają inne znaczenie. Ów kod jest złożony z krótkich i długich „pisków”, konkretna sekwencja odpowiada danemu problemowi. Znaczenie sekwencji jest zazwyczaj opisane w instrukcji obsługi.

W taki sposób można zdiagnozować, co jest przyczyną niedziałania naszego serwera.

Jeśli nie byliśmy w stanie zdiagnozować dlaczego serwer nie działa, możemy podjąć kolejne kroki:

Odłączamy wszystkie kable, a następnie czekamy co najmniej 10 sekund i na nowo podłączamy kable. Podpinamy pod serwer kompatybilną klawiaturę oraz monitor i próbujemy uruchomić serwer.

Jeśli nadal nie działa, musimy wykonać kolejne działania. W tym celu odłączamy wszystkie kable, otwieramy obudowę serwera i:

- Od płyty głównej odłączamy wszystkie elementy, które nie są potrzebne do pracy minimalnej,

- Z pamięci RAM odłączamy wszystkie moduły, które nie są potrzebne do pracy minimalnej

- Odłączamy karty PCI/PCIe

- Podłączamy wszystkie potrzebne kable i próbujemy uruchomić serwer.

Jeśli nadal nam się nie uda, to zostaje wymiana podzespołów (RAM, zasilacz, procesor, płyta główna).

Przedstawione rozwiązania są jedynie wskazówką. Naprawę tak skomplikowanych maszyn należy powierzać fachowcom.

Views

Views

Liked

Liked

Krótki opis najczęstszych problemów jakie występują z serwerami oraz jak je naprawić.